python日志模块配置

import logginglogging.basicConfig(filename= 'out.log',filemode= 'w ', level= logging.DEBUG, format= '%(asctime)s - %(levelname)s - %(message)s')filename:日志文件夹名称filemode:文

import logginglogging.basicConfig(filename= 'out.log',filemode= 'w ', level= logging.DEBUG, format= '%(asctime)s - %(levelname)s - %(message)s')filename:日志文件夹名称filemode:文

1. 安裝pylint应用pip install pylint安裝 2. 常见的命令行参数:--generate-rcfile :能够应用 pylint --generate-rcfile 来转化成一个配置文件实例。能够应用跳转把这个配置文件储存出来用作之后应用。还可以在前面再加其他选项,使这种选项的值被包括在这个造成的配置文件里。如:p

国内镜像命令行:pip install -i https://pypi.tuna.tsinghua.edu.cn/simple ×××PyCharm:https://pypi.tuna.tsinghua.edu.cn/simple 别的指令升級pip install --upgrade 库名特定版本pip install scipy==

pip install 安裝第三方插件是出現Could not fetch URL https://pypi.python.org/simple/pool/: There was a problem confirming ssl certificate难题解决办法以下:在python安装目录下建立pip.ini,pip.ini配置內容以下

一、常量(*****) 常量:what:不可以被改变的量why:在程序运行过程中,有些值是固定的、不应该被改变how:约定俗成是用全部大写的变量名表示常量go语言 :const age int=18#改了就报错,可保障代码质量python:AGE=18#py常量改了代码不报错,代码质量保障不了二、基本数据类型 (*****)1、数字类型

懒加载在前端开发中的实际意义:懒加载的关键目地便是做为网络服务器前端开发的提升,降低恳求频次或是延迟时间恳求数。完成基本原理: 先加载一部分数据信息,当开启某一标准时运用多线程加载剩下的数据信息,新获得的数据信息不容易危害原来数据信息的显示信息,另外最大幅的降低服务端資源损耗。完成方法:1. 第一种时纯碎的延迟时间加载,应用setTime

from docx import Documentfrom docx.shared import Pt,RGBColorfrom docx.oxml.ns import qnw=Document(r'D:\word训练\训练.docx')for paragraph in w.paragraphs:for run in

前言最近上网冲浪的时候看到了一个有趣的东西,叫做『人物动漫化』,作为老大的粉丝,怎么可能放过这个机会,让我们先看看效果图: 这就是这次要用Python搞的事情啦,我们会利用百度AI的人物动漫化技术,结合Python对图片进行处理,生成动漫图片。 开始敲代码老规矩先来敲代码,导入所需库import base64import reques

此系列文档:1. 我终于弄懂了Python的装饰器(一)2. 我终于弄懂了Python的装饰器(二)3. 我终于弄懂了Python的装饰器(三)4. 我终于弄懂了Python的装饰器(四)一、装饰器基础(什么是装饰器)Python的函数是对象要了解装饰器,您必须首先了解函数是Python中的对象。这具有重要的联系。让我们来看一个简单的例子

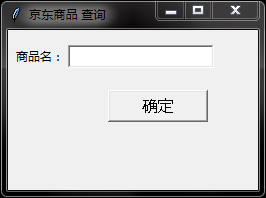

最近写了个专门爬百度的,后来又想爬京东的,还是采用上次的BeautifulSoup+requests模块#!/usr/bin/env python# -*- coding: utf-8 ########import###############import requestsfrom bs4 import BeautifulSoup#fro

Python为啥这么火,这么多人学,就是因为简单好学,功能强大,整个社区非常活跃,资料很多。而且这语言涉及了方方面面,比如自动化测试,运维,爬虫,数据分析,机器学习,金融领域,后端开发,云计算,游戏开发都有涉及。万丈高楼平地起,Python这座大厦能够如此强大,就是拥有强大的成千上万的库的支持,无数牛逼的轮子在支持这座大厦, 今天我们来一

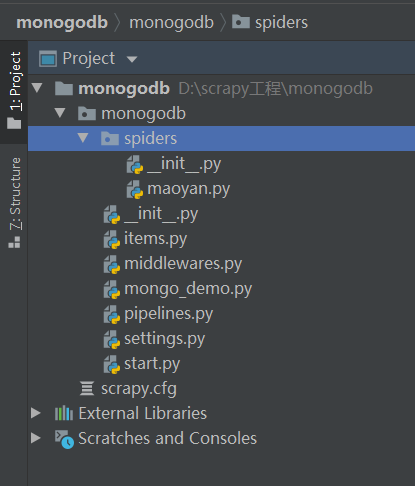

前言 一般我们都会将数据爬取下来保存在临时文件或者控制台直接输出,但对于超大规模数据的快速读写,高并发场景的访问,用数据库管理无疑是不二之选。首先简单描述一下MySQL和MongoDB的区别:MySQL与MongoDB都是开源的常用数据库,MySQL是传统的关系型数据库,MongoDB则是非关系型数据库,也叫文档型数据库,是一

一、python解释器安装参考视频 : https://www.bilibili.com/video/BV1Xz4y1Q7bZps:注意设置环境变量(文件是操作系统的概念,操作系统优先在当前文件夹找,找不到就到环境变量path找)python解释器不兼容解释器下载官网:python.org二、运行python程序的方式及程序运行步骤 运行

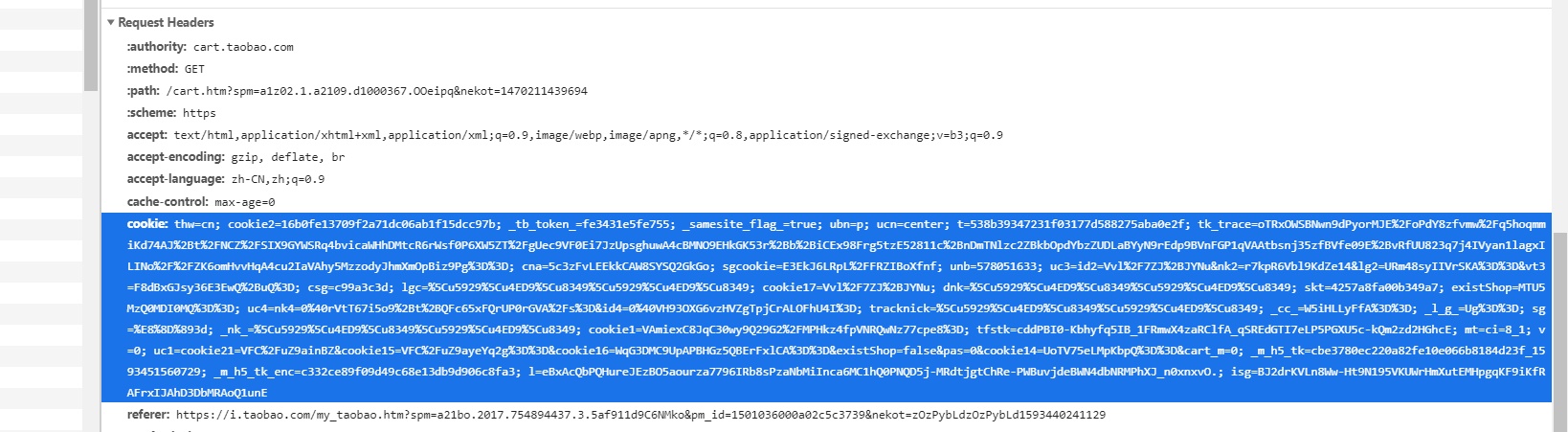

我们知道,有的网页必须要登录才能访问其内容。scrapy登录的实现一般就三种方式。1.在第一次请求中直接携带用户名和密码。2.必须要访问一次目标地址,服务器返回一些参数,例如验证码,一些特定的加密字符串等,自己通过相应手段分析与提取,第二次请求时带上这些参数即可。可以参考https://www.cnblogs.com/bertwu/p/1

1.装饰器代码:import timedef timer(func): #timer(test1)def deco(*args,**kwargs): # *args是为了装饰不同的函数,因为有的函数是需要传参数,有的不需要start_time=time.time()res=func(*args,**kwargs) #run test1

1.涵数编码:def test(x,y):print(x)print(y)test(y=2,x=1)#关键词主要参数 与形参次序不相干test(1,2)#部位主要参数 与形参一一对应test(1,y=2)#如果有好几个主要参数,关键词主要参数要放到部位主要参数后边View Code2.时间轴import sys,time #导进包f

1.练习 需求:三级菜单,输入目录地址进入下一级菜单代码:area={'hubei':{'huanggang':['qichun','wuxue','huangzhou'], 'wuhan':['wuchang','hankou','hongshan']},'jiangsu':{'nanjing':['jianye','baixia'

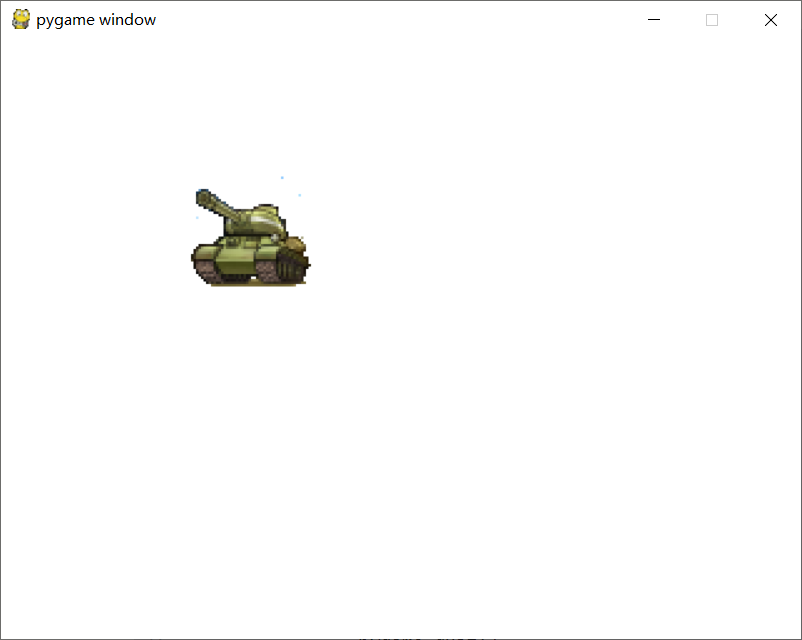

pygame 的精灵应用pygame.sprite.Sprite 是 pygame 中用于完成精灵的一个类,在应用时并不一定对它实例化,只必须承继它,随后按需写成自身的类,因而比较简单、应用。1. 精灵精灵能够被觉得是一个个小图(帧)编码序列(比如角色走动),它能够在显示屏上挪动,而且能够与别的图型目标互动。精灵图象能够是用 pygame

from docx import Documentfrom docx.oxml.ns import qn #字体样式w=Document()table=w.add_table(3,3,style='Medium Grid 1 Accent 1')table_head=table.rows[0].cellstable_head[

from docx import Documentfrom docx.shared import Cmfrom docx.enum.table import WD_TABLE_ALIGNMENT#设定表格两端对齐方法w=Document(r'D:\word训练\训练.docx')table=w.tables[0]table.

SEO优化/竞价信息流托管/百度360搜狗推广开户/网站定制开发/建设推广流程